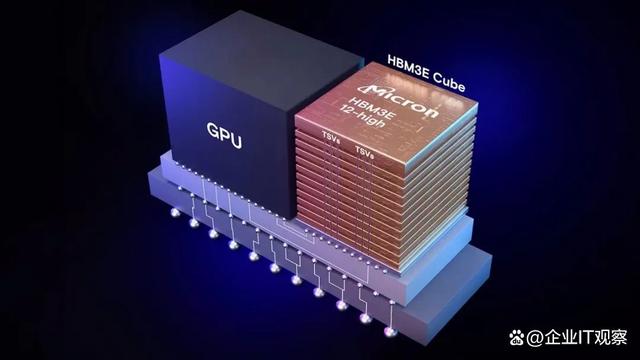

美光正式推出了12-Hi HBM3E内存,每芯片容量可达36GB,带宽可达1.2TB/s,即数量可达9.2GT/s,主要用于面向AI和HPC工作负载的高端处理器,典型如Nvidia的H200和B100/B200 GPU。

相较于美光之前的8-Hi版本(24GB),新的12-Hi HBM3E容量提升了50%。容量的增加意味着能在单个处理器上运行更大的AI模型,比如Llama 2,其参数高达700亿个。并且,更大的内存空间可以降低卸载CPU的问题,同时减少GPU之间的通信延迟,从而实现更快数据处理速度。

在性能方面,美光12-Hi HBM3E可提供超过1.2TB/s的内存带宽,数据传输速率超过9.2GT/s。美光还指出,尽管内存容量比竞争对手高出50%,但其功耗却低于8-Hi HBM3E。即容量更大,但功耗更低。

美光的12-Hi HBM3E包含一个完全可编程的内存内置自检(MBIST)系统,以为企业提供更高的性能和可靠性。该技术可以全速模拟系统级流量,从而可以对新系统进行全面测试和更快的验证。

据美光介绍,美光的HBM3E内存设备与台积电的CoWoS封装技术兼容,该技术被广泛用于Nvidia的H100和H200等GPU上。

目前,美光正在向其主要合作伙伴提供12-Hi HBM3E样品,以进行更广泛的AI生态系统测试。